Cloud Platform เป็นแพลตฟอร์มให้เช่าพื้นที่เก็บข้อมูล การประมวลผล และบริการอื่นๆ ผ่านทางอินเทอร์เน็ตโดยไม่ต้องมีเซิร์ฟเวอร์์ตั้งอยู่ ซึ่งตัวที่ได้รับความนิยมในตลาด เช่น AWS, Azure, Google Cloud Platform (GCP) เป็นต้น ปัจจุบันองค์กรที่กำลังจะย้ายข้อมูลจาก On-Premise มาใช้เป็น Cloud Computing มักมีข้อสงสัยว่า การเลือกใช้คลาวด์ควรเลือกใช้ตัวไหนให้เหมาะสมกับองค์กรตนเองมากที่สุด

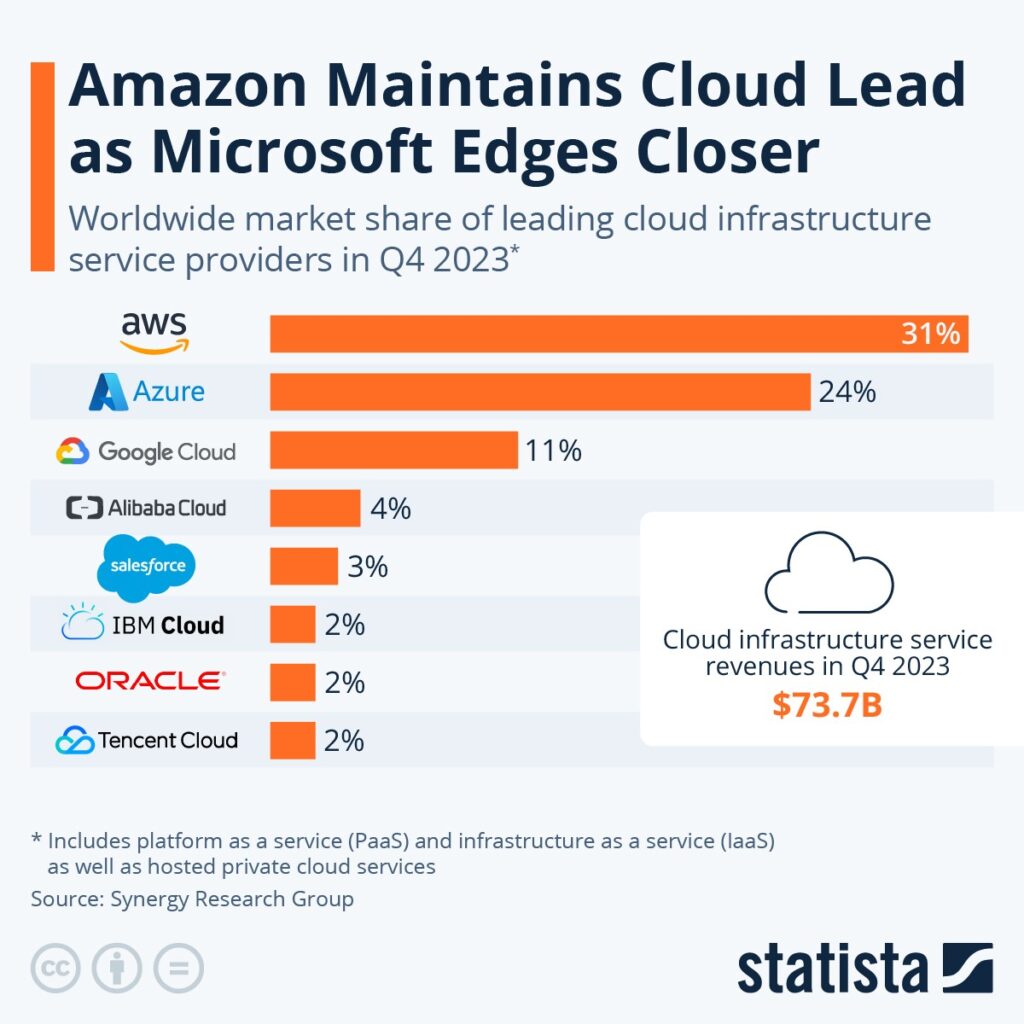

โดยสถิติที่ผ่านมา Azure และ GCP เป็นผู้นำทางในตลาด Cloud Infrastructure พร้อมทำการครองส่วนแบ่งทางการตลาดถึง 66% ในไตรมาสที่ 4 ปี 2023 (AWS 31%, Azure 24%, Google Cloud 11% [ข้อมูลจาก Synergy Research Group] ดังนั้น การที่จะเลือกการจัดเก็บข้อมูลที่เหมาะสมก็เป็นสิ่งที่จำเป็นต่อทุกองค์กร ดังนั้นก่อนอื่นจำเป็นต้องรู้ถึงกระบวนการของแต่ละแพลตฟอร์มเสียก่อน ซึ่งทางไซเจ็นจึงแชร์ข้อมูลการเปรียบเทียบกระบวนการทำงานจัดการข้อมูลและเครื่องมือที่นิยมใช้ของ Azure และ GCP ผ่านบทความนี้

ทำความรู้จัก Data Pipeline กระบวนการจัดการข้อมูลตั้งแต่เริ่มจนจบ

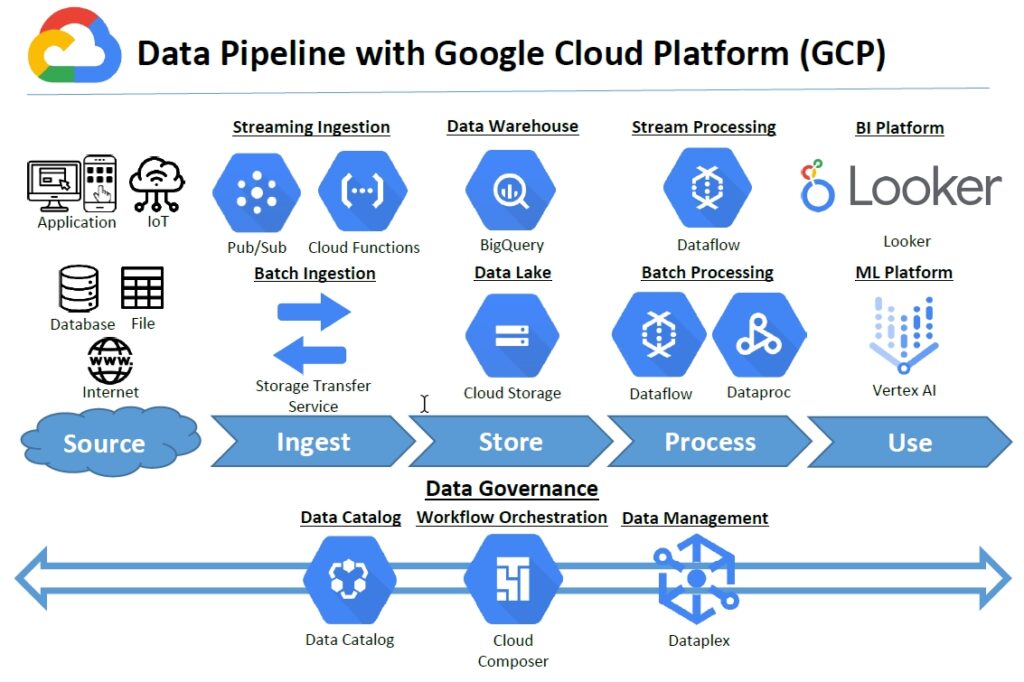

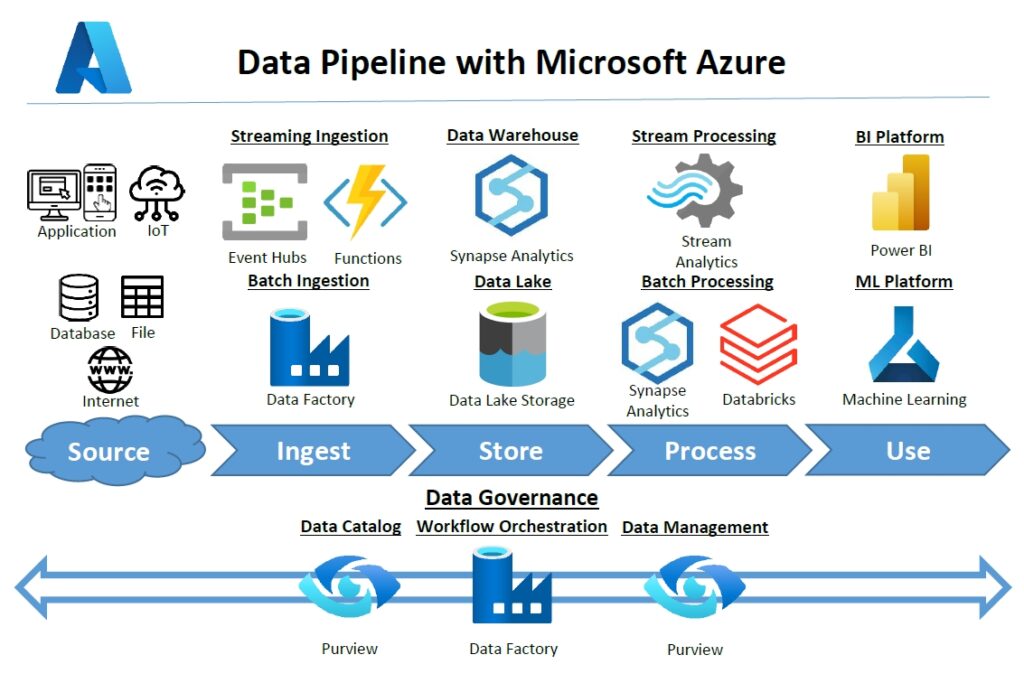

Data Pipeline คือ ขั้นตอนกระบวนการจัดการข้อมูลตั้งแต่ต้นทางจากแหล่งข้อมูลต่างๆ เช่น ข้อมูลจากเครื่อง IoT ข้อมูลจากฐานข้อมูล (Database) ขององค์กร ข้อมูลไฟล์ Excel จากแผนกต่างๆ ให้เคลื่อนย้ายไปจนถึงปลายทางโดยให้ข้อมูลพร้อมใช้งานกับความต้องการของผู้ใช้งาน เช่น งานด้าน Business Intelligence ของนักวิเคราะห์ข้อมูล งานด้าน Artificial Intelligence ของนักสร้างระบบ AI ซึ่ง Data Pipeline ก็จะมีมาตรฐานที่ดีและถูกต้อง ดังนี้

- ความเข้าถึงได้สะดวกของข้อมูล (Accessibility) – ผู้ใช้ข้อมูลอย่างนักวิเคราะห์ข้อมูลหรือคนอื่นๆ ในองค์กรควรเข้าถึงข้อมูลได้ง่าย ครบและตรงกับสิ่งที่ต้องการ

- ความสามารถในการรองรับการขยายขนาดของข้อมูล (Scalability) – ออกแบบให้ระบบ Data Pipeline มีราคาที่ย่อมเยา สามารถรองรับข้อมูลจำนวนมากได้เมื่อปริมาณข้อมูลเพิ่มมากขึ้น

- ประสิทธิภาพ (Efficiency) – ข้อมูลพร้อมนำไปใช้ตามความต้องการของธุรกิจ

- ง่ายต่อการตรวจสอบและหาปัญหา (Monitoring) – มีระบบการแจ้งเตือนเมื่อ Data Pipeline เกิดปัญหา

- ความปลอดภัย (Security) – เนื่องจากข้อมูลถือเป็นสิ่งสำคัญ การเก็บข้อมูลให้ไม่รั่วไหลสู่ระบบภายนอกจึงเป็นสิ่งจำเป็น

โดยหลักๆแล้ว Data Pipeline จะมีกระบวนการอยู่ 4 ขั้นตอน ซึ่งเรานำเครื่องมือของ Azure และ GCP มาให้ดูการเปรียบเทียบ ดังด้านล่าง

ขั้นตอนที่ 1 Ingest (การดึงข้อมูล)

ขั้นตอนนี้จะเป็นการดึงหรือเคลื่อนย้ายข้อมูลจาก Source หรือแหล่งข้อมูลที่มาจากหลายๆ แหล่ง เช่น Application เครื่อง IoT ฐานข้อมูล (Database) ไฟล์ต่างๆ หรือ ไฟล์ Excel ไปรวมกันที่แหล่งเก็บข้อมูลซึ่งในระบบคลาวด์อย่าง Azure Data Lake Storage หรือ Google Cloud Storage ที่เป็นเครื่องมือในการเก็บข้อมูล โดยทั่วไปแล้วการดึงข้อมูลจะแบ่งเป็น 2 ประเภทตามด้านล่างนี้

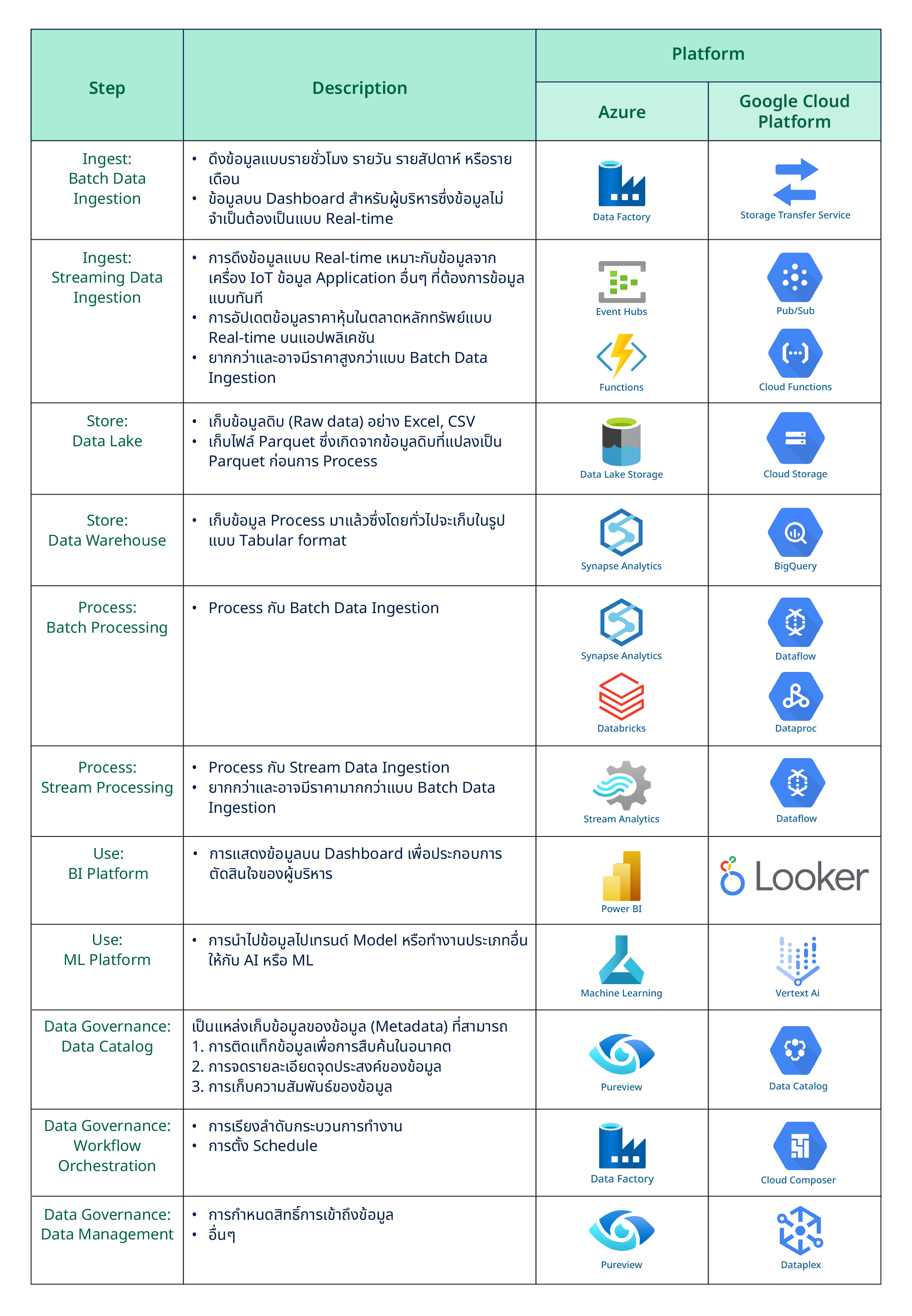

- Batch Data Ingestion (การดึงข้อมูลแบบกลุ่ม) ซึ่งก็คือการดึงข้อมูลตามช่วงเวลาที่กำหนดไว้ โดยปกติแล้วอาจตั้งการดึงข้อมูลแบบรายชั่วโมง รายวัน รายสัปดาห์ หรือรายเดือน วิธีนี้จะเหมาะกับข้อมูลที่ไม่ได้มีเวลาเป็นข้อจำกัดอย่างเช่นข้อมูลบน Dashboard สำหรับผู้บริหารซึ่งข้อมูลไม่จำเป็นต้องเป็นแบบ Real-time ในหลายๆ กรณี การดึงข้อมูลเป็นรายชั่วโมงหรือรายวันก็เพียงพอต่อการนำไปวิเคราะห์ธุรกิจ เครื่องมือที่นิยมใช้สำหรับ Batch Data Ingestion คือ Azure Data Factory หรือ Google Cloud Storage Transfer Service

- Streaming Data Ingestion (การดึงข้อมูลแบบต่อเนื่อง) ซึ่งก็คือการดึงข้อมูลแบบ Real-time หรือใกล้เคียง Real-time วิธีนี้จะเหมาะกับข้อมูลจากเครื่อง IoT ข้อมูล Application อื่นๆ ที่ต้องการข้อมูลแบบทันทีอย่างเช่นการตรวจอัตราการเต้นของชีพจรหรือ Heart Rate โดยใช้ Sensor ของเครื่อง IoT หรือการอัปเดตข้อมูลราคาหุ้นในตลาดหลักทรัพย์แบบ Real-time บนแอปพลิเคชัน วิธีนี้จะยากกว่าและอาจมีราคามากกว่าแบบ Batch Data Ingestion เครื่องมือที่นิยมใช้คือ Azure Event Hubs หรือ Google Cloud Pub/Sub

ขั้นตอนที่ 2 Store (การเก็บข้อมูล)

หลังจากที่ดึงข้อมูล (Ingest) มาแล้ว ข้อมูลจะถูกนำมาเก็บไว้ที่ระบบเก็บข้อมูลหรืออีกรูปแบบคือ Process หรือปรับเปลี่ยนข้อมูลก่อน (ซึ่งจะอธิบายในขั้นตอนถัดไป) แล้วจึงไปเก็บไว้ในระบบเก็บข้อมูล โดยทั่วไปแล้วข้อมูลดิบ (Raw data) จะถูกนำมาเก็บไว้ใน Data Lake อย่าง Azure Data Lake Storage หรือ Google Cloud Storage แต่หากข้อมูลมีการปรับเปลี่ยนมาแล้ว อาจนำมาเก็บไว้ใน Data Warehouse อย่าง Azure Synapse Analytics หรือ Google Cloud BigQuery

ขั้นตอนที่ 3 Process (การปรับเปลี่ยนข้อมูล)

หลังจากที่ดึงข้อมูล (Ingest) มาแล้ว เราอาจเก็บข้อมูล (Store) ไว้ในระบบเก็บข้อมูลก่อนหรือจะนำมา Process เลยก็ได้แล้วจึงไป Store ข้อมูล การ Process ข้อมูลคือการแปลงข้อมูลด้วยวิธีการต่างๆ เช่น การ Deduplicate ข้อมูลหรือลบข้อมูลที่ซ้ำกัน การจัด Format ให้ตรงกันเช่น สกุลเงินให้เป็นหน่วยเดียวกัน วันที่ให้เป็นรูปแบบเดียวกัน พร้อมกับปรับเปลี่ยนข้อมูลตาม Business Logic เพื่อให้ข้อมูลอยู่ในรูปแบบที่พร้อมใช้งาน โดยเครื่องมือที่จะนำมา Process กับ Batch Data Ingestion จะมีอย่างเช่น Azure Synapse Analytics หรือ Google Cloud Dataflow ที่ใช้ Process กับ Streaming Data Ingestion อย่าง Azure Stream Analytics หรือ Google Cloud Dataflow (เป็นเครื่องมือที่ใช้ได้กับ Ingestion ทั้งสองแบบ)

ขั้นตอนที่ 4 Use (การใช้งานของข้อมูล)

นำมาข้อมูลมาใช้งานตามจุดประสงค์ซึ่งอาจเป็นการแสดงข้อมูลบน Dashboard ด้วยเครื่องมืออย่าง Microsoft Power BI หรือ Looker การนำไปข้อมูลไปเทรนด์ Model ให้กับ AI อย่าง Azure Machine Learning หรือ Google Cloud Vertex AI การนำข้อมูลมาเป็นส่วนหนึ่งในระบบแจ้งเตือนผ่านทาง SMS หรืออีเมล และอื่นๆ

ทุกขั้นตอนใน Data Pipeline อาจมีการทำ Data Governance มาสร้างมาตรฐานในการกำกับ ดูแล และรักษาข้อมูลตั้งแต่แหล่งข้อมูล (Source) การดึงข้อมูล (Ingest) การเก็บข้อมูล (Store) การปรับเปลี่ยนข้อมูล (Process) และการใช้งานของข้อมูล (Use) วิธีการทำ Data Governance เช่น

- Data Catalog คือแหล่งเก็บข้อมูลของข้อมูล (Metadata) ที่ช่วยในเรื่องของการติดแท็กข้อมูลให้สามารถหาข้อมูลได้ง่ายขึ้น การจดรายละเอียดจุดประสงค์ของข้อมูลว่าข้อมูลใช้ทำอะไร การเก็บความสัมพันธ์ของข้อมูลด้วยเครื่องมืออย่าง Azure Purview หรือ Google Cloud Data Catalog

- Workflow Orchestration คือการเรียงลำดับกระบวนการทำงานว่าขั้นตอนไหนควรเริ่มก่อนหรือหลังและการตั้ง Schedule ว่า Data Pipeline ควรเริ่มทำงานตอนไหนด้วยเครื่องมืออย่าง Azure Data Factory หรือ Google Cloud Composer

- Data Management ด้านอื่นๆ อย่างเช่นการกำหนดสิทธิ์การเข้าถึงข้อมูลว่าใครเข้าดูข้อมูลส่วนไหนได้บ้าง

ตารางสรุปเปรียบเทียบเครื่องมือของ Azure และ GCP ที่นิยมใช้

ทั้ง Azure และ GCP ต่างมีเครื่องมือตัวอื่นอีกหลายตัวที่ใช้แทนกันในแต่ละขั้นตอนได้ ซึ่งเครื่องมือแต่ละตัวจะมี Use Case ที่แตกต่างกัน จึงควรพิจารณาจากหลายๆ องค์ประกอบของเครื่องมือแต่ละตัวก่อนการตัดสินใจเลือกใช้ หรือหากต้องการคำแนะนำหรือมีข้อสงสัย สามารถติดต่อสอบถามและขอคำปรึกษากับทางทีม ZyGen ได้เลย คลิก

References:

- Azure vs GCP (Google Cloud Platform): Which One to Choose?

- Scalable Efficient Big Data Pipeline Architecture

- สร้าง Data Pipeline ด้วย Google Cloud

- Batch vs. Streaming Data Ingestion: Choosing the Right Approach for Efficient Data Processing

- Azure documentation

Author: Pornpat S.